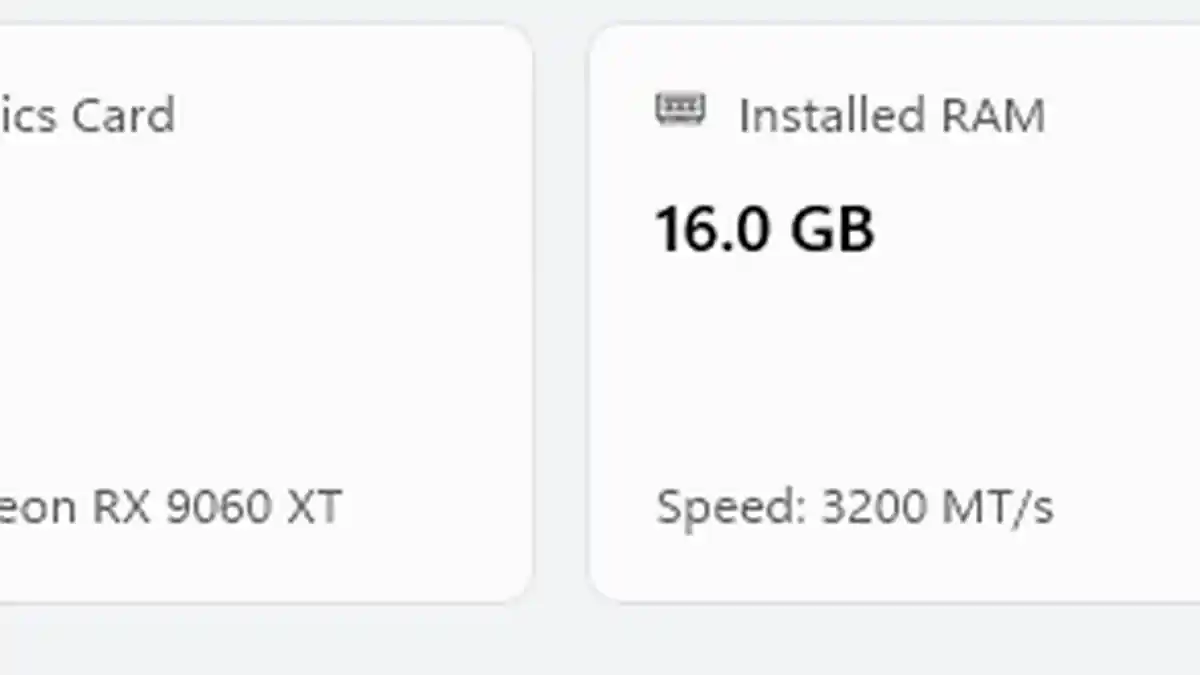

Bonjour, je suis assez nouveau dans l’utilisation d’ollama et le fonctionnement des LLM localement, mais j’ai réussi à charger le modèle gpt-oss:20b sur mon MacBook M1 avec 16 Go de RAM et cela fonctionne correctement, bien que très lentement. J’ai essayé de l’installer sur mon ordinateur de bureau Windows pour comparer les performances, mais j’ai reçu l’erreur « 500 : le layout de mémoire ne peut pas être alloué ». Je suppose que cela signifie que je n’ai pas assez de vRAM/RAM pour charger le modèle, mais cela m’étonne car j’ai également 16 Go de vRAM ainsi que 16 Go de RAM système, ce qui semble comparable à mon MacBook. Donc, ai-je vraiment besoin de plus de mémoire ou y a-t-il quelque chose que je fais mal qui empêche le fonctionnement du modèle ? J’ai joint une photo de mes spécifications système pour référence, merci !

Je ne comprends pas comment les gens possèdent des ordinateurs de 16 Go en 2025, Windows seul en a besoin de 12 Go et plus. Achetez donc un peu de mémoire vive.

Toutes les couches en vram sont d’environ 12 Go.

Cela. Même chose sur le mien, avec 16 Go de VRAM et 32 Go de RAM. J’ai utilisé LM Studio sous Windows 10.

Ça semble indiquer que vous le chargez dans la mémoire RAM du système et donc qu’il n’y a pas tout 16 Go disponibles car ils sont partagés avec le système d’exploitation et les autres applications chargées. Vérifiez votre application IA pour le charger en VRAM.

nous parlons du modèle 20b…