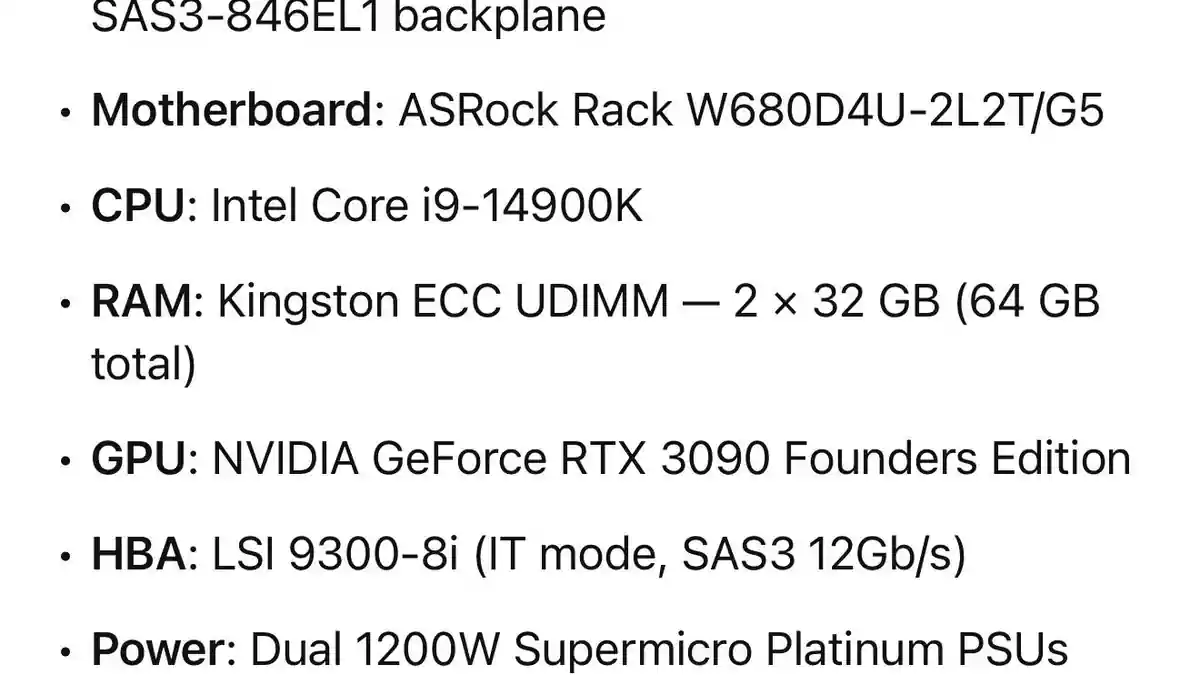

Je cherche à améliorer mon installation actuelle et à reconstruire. Elle sera principalement utilisée pour Plex et l’utilisation de modèles de langage (LLM). Un Core i9-14900 pour gérer les transcodages multiples, et une RTX 3090 pour les modèles 13b/30b. Je suis ouvert à tous les retours sur ce projet, n’hésitez pas à critiquer s’il existe de meilleures alternatives. C’est un peu un build « ultime », du moins je l’espère… mais avec les homelabs, c’est jamais vraiment fini.

Ça n’a pas d’importance si le 3090 a la moitié de la vram. Si la vram est saturée et doit commencer à utiliser la mémoire système, vous ajoutez maintenant des heures. Plus de vram est essentiel.

Ce processeur est excessif, si vous voulez rester sur un processeur grand public, les i7 de 12e ou 13e génération sont encore largement suffisants. Passez par eBay et cherchez un processeur Xeon/EPYC et une carte mère. Quel que soit le processeur que vous utilisez, associez-le à une carte graphique A380 et vous obtiendrez une machine Plex monstrueuse. Assurez-vous simplement d’avoir assez d’emplacements GPU ; c’est là que les cartes mères serveur excellent, car vous aurez probablement la possibilité d’ajouter plus de GPU plus tard si vous souhaitez augmenter votre puissance pour les LLM.

this is not the best for either. Concentrate on the LLM side, Plex can be a container with like 8 gb memory and access to the GPU.

Too little and too slow system ram, you want to be at least in the 6000+ MT range and 128GB plus. SAS3 is too slow for LLM, get an NVME PCIE JBOD card

With what you have now you will be relegated to 24 gb of vram, Even at 27B, your context increase will eat an additional 5-6 GB for 64k or 128k context. The system memory is too slow to offload anything to and keep T/s sane.

Entry level LLM build yes, max quant is 4 at 27-30b.

Plex utilisera environ 4 % de cela. Il fonctionne bien sur un N100 ou sur un ancien PC de bureau avec une puce Intel de 9e génération. Tout aussi bien.

Pour les LLM, c’est encore un peu moyen… cette 3090 fonctionnera pour des modèles plus petits comme Llama 3.2 8b, mais vous ne pourrez pas dépasser cela de beaucoup. La VRAM est essentielle. Pensez à vous procurer un Intel B60 avec 48 Go de VRAM… il dispose d’excellents moteurs de transcodage et répondra bien mieux à vos besoins en matière de LLM.

Les modèles de langage ont-ils vraiment besoin d’autant de RAM ? Je croyais que c’était surtout une question de mémoire vidéo.

Je devine que c’est un serveur tout-en-un avec du stockage, Plex et des LLMs, puisque c’est sous Unraid. Si l’OP veut des pools ZFS qui bénéficieront d’une mise en cache RAM, Plex peut transcoder sur un disque RAM pour économiser l’usure des SSD, et les LLMs pourraient utiliser la RAM système comme déversoir si le modèle ne tient pas dans la VRAM, bien que cela fonctionnera beaucoup plus lentement. Dans ce cas d’usage, 64 Go n’est pas excessif, cela dépend de la quantité de stockage prévue et des autres conteneurs/machines virtuelles.

Mec, je peux te donner un ordinateur que j’ai monté en 2012 et tu pourras faire tourner Plex dessus. T’as pas besoin de la 3090 là-dedans, tu peux juste utiliser Quick Sync avec ton processeur pour le transcodage matériel. J’utilise Unraid aussi et mon ordi a 16 Go de RAM avec un i5 8600k. Je n’ai aucun problème du tout. J’ai genre 10 applis Docker qui tournent et mon utilisation ne dépasse jamais 50 %.

Le 3090 est destiné aux tâches d’IA de type LLM.

Ohhh d’accord. Plex ne demande pas grand-chose en fait. Je recommande toujours de l’installer sur un disque rapide, d’avoir un type de transcodage matériel si vous payez l’abonnement Plex Pass et une bonne connexion réseau pour un usage externe.